共计 1454 个字符,预计需要花费 4 分钟才能阅读完成。

在人工智能(AI)应用程序中,解释模型决策的能力变得越来越重要。一些机器学习算法可以通过生成规则或决策树来解释其输出结果,但是深度学习模型通常很难解释其预测结果。为了克服这个问题,研究人员和从业者开发了各种可解释性 AI 技术,其中包括 LIME 和 SHAP 等方法。

在过去的几年中,深度学习已经取得了巨大的成功,成为了许多领域中最佳的机器学习算法之一。然而,深度学习模型通常被认为是黑盒子,因为它们对于非常复杂的输入数据集产生的输出结果很难解释。

尽管深度学习模型通常能够提供准确的预测,但如果无法了解它们是如何得出这些预测的,那么它们就很难被人接受。对于一些领域,例如医疗诊断或自动驾驶汽车,解释和可解释性变得尤为重要。因此,可解释性 AI 技术应运而生。

1. LIME 方法及其实例

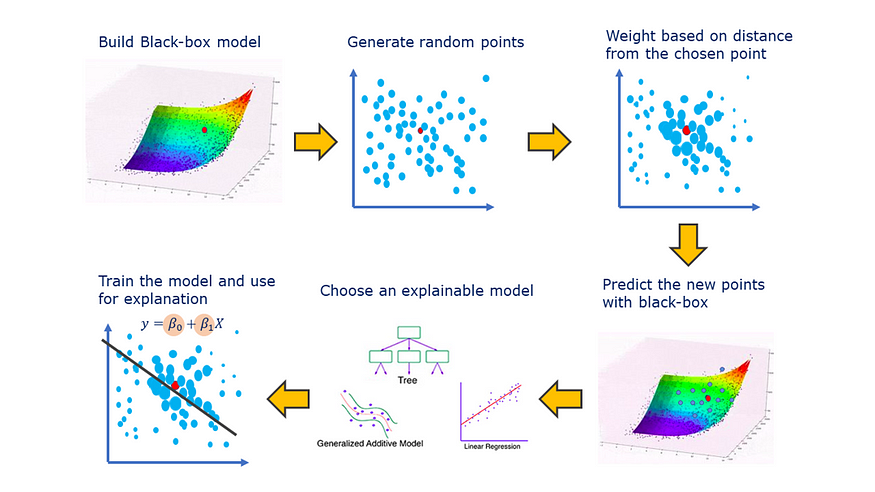

LIME(局部可解释性模型解释)是一种机器学习算法,可以帮助解释深度学习模型的决策结果。LIME 的主要思想是在输入数据周围构建一个线性模型来近似深度学习模型的决策过程。该算法使用局部加权回归来确定每个特征的影响,并生成一组局部解释。

以下是一个使用 LIME 算法解释图像分类模型的例子。假设有一个图像分类模型,可以将图像分为猫和狗。如果我们有一个测试集中的图像,我们可以使用 LIME 算法来揭示模型是如何进行分类的。

首先,我们需要定义一个区域,这个区域包括了图像中的特定像素,例如前 500 个像素。然后,我们生成一组虚拟数据点,在此虚拟数据点上,我们通过增加或减少每个像素的值来扰动图像。接下来,我们将虚拟数据点输入到模型中,并记录输出结果。

使用 LIME 算法,我们可以确定哪些像素最具有影响力。例如,在狗的分类中,模型可能会关注图像中狗的眼睛和嘴巴的位置。

2. SHAP 方法及其实例

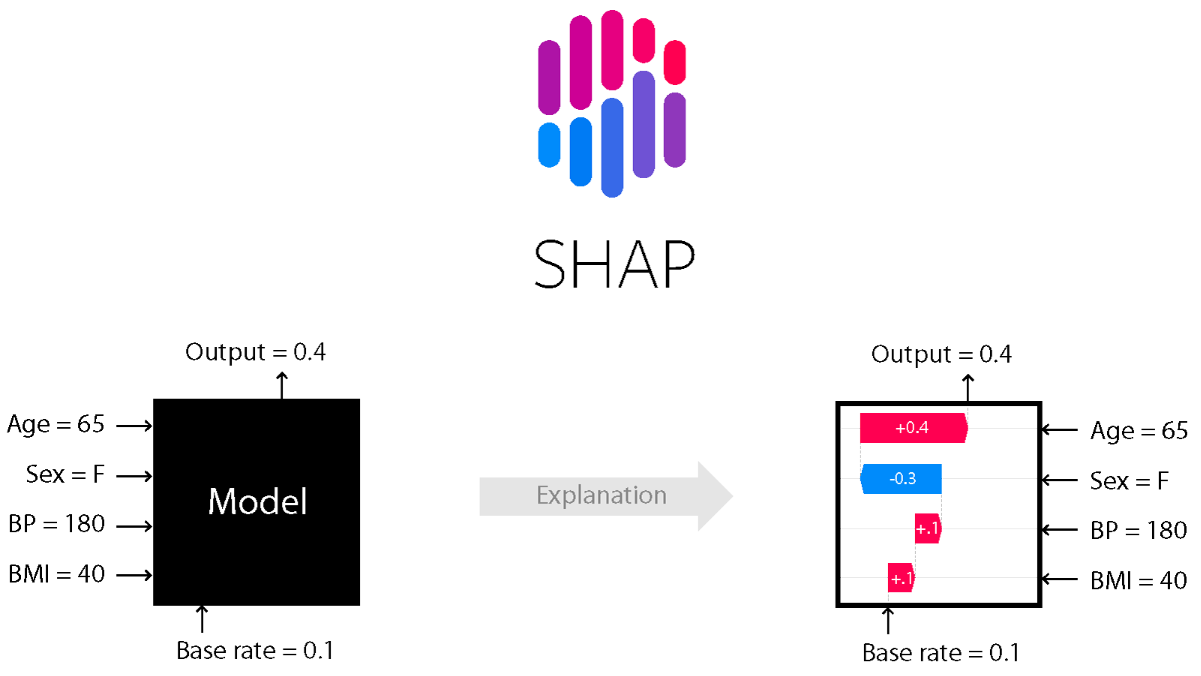

SHAP(Shapley Additive Explanations)是一种机器学习算法,用于解释深度学习模型的输出结果。与 LIME 不同,SHAP 使用博弈论中的 Shapley 值来确定每个特征对于模型预测的贡献,从而提供更准确和全面的解释。

以下是一个使用 SHAP 算法解释文本分类模型的例子。假设有一个文本分类模型,可以将文章分为政治、体育和经济三类。我们可以使用 SHAP 算法来揭示模型如何对文本中的单词进行分类。

首先,我们需要对文本进行处理,例如将每个单词表示为向量。然后,我们通过将所有文章传递给模型来生成预测输出。接下来,我们使用 SHAP 算法来确定哪些单词最具有影响力。例如,在政治文章的分类中,模型可能会关注某些政治术语或特定的国家名字。

3. PyTorch 与可解释性 AI 技术的结合应用

PyTorch 是一种常用的深度学习框架,提供了各种工具和库,使开发人员能够轻松构建和训练深度学习模型。在 PyTorch 中,我们可以使用 LIME 和 SHAP 等可解释性 AI 技术来解释模型的输出结果。

例如,我们可以使用 PyTorch 构建一个图像分类模型,并使用 LIME 和 SHAP 来解释模型的预测结果。使用 LIME,我们可以确定哪些像素最具有影响力,从而提供更详细和局部化的解释。而使用 SHAP,我们可以确定哪些特征对于整个模型预测的贡献最大,从而提供更全面和准确的解释。

结论

总之,可解释性 AI 技术在深度学习领域中变得越来越重要。使用 LIME 和 SHAP 等技术,可以帮助我们了解深度学习模型是如何做出决策的,并提供更详细和全面的解释。在 PyTorch 中,我们可以轻松地使用这些可解释性 AI 技术来解释模型的预测结果。

原文地址: PyTorch 中的可解释性 AI 技术:LIME 和 SHAP 等方法